Deployments

Содержание

Понимание Deployments

Обратитесь к официальной документации Kubernetes: Deployments

Deployment — это ресурс высокого уровня в Kubernetes для управления и обновления реплик Pod'ов декларативным способом. Он предоставляет надежный и гибкий способ определить, как должно работать ваше приложение, включая количество поддерживаемых реплик и безопасное выполнение rolling update.

Deployment — это объект в API Kubernetes, который управляет Pods и ReplicaSets. При создании Deployment Kubernetes автоматически создает ReplicaSet, который отвечает за поддержание заданного количества реплик Pod'ов.

Используя Deployments, вы можете:

- Декларативное управление: определить желаемое состояние приложения, и Kubernetes автоматически обеспечит соответствие фактического состояния кластера желаемому.

- Контроль версий и откат: отслеживать каждую ревизию Deployment и легко откатываться к предыдущей стабильной версии при возникновении проблем.

- Обновления без простоя: постепенно обновлять приложение с помощью стратегии rolling update без прерывания сервиса.

- Самовосстановление: Deployment автоматически заменяет экземпляры Pod, если они падают, завершаются или удаляются с узла, обеспечивая постоянное наличие заданного количества Pod'ов.

Как это работает:

- Вы определяете желаемое состояние приложения через Deployment (например, какой образ использовать, сколько реплик запускать).

- Deployment создает ReplicaSet, чтобы обеспечить запуск указанного количества Pod'ов.

- ReplicaSet создает и управляет фактическими экземплярами Pod.

- При обновлении Deployment (например, смена версии образа) создается новый ReplicaSet, который постепенно заменяет старые Pod'ы новыми согласно стратегии rolling update, пока все новые Pod'ы не запустятся, после чего удаляется старый ReplicaSet.

Создание Deployments

Создание Deployment с помощью CLI

Предварительные требования

- Убедитесь, что

kubectlнастроен и подключен к вашему кластеру.

Пример YAML файла

Создание Deployment через YAML

Создание Deployment через веб-консоль

Предварительные требования

Получите адрес образа. Источником образов могут быть репозитории образов, интегрированные администратором платформы через toolchain, либо репозитории образов сторонних платформ.

- В первом случае администратор обычно назначает репозиторий образов вашему проекту, и вы можете использовать образы из него. Если нужный репозиторий образов не найден, обратитесь к администратору для выделения.

- Если это репозиторий образов сторонней платформы, убедитесь, что образы можно напрямую загрузить из него в текущем кластере.

Процедура — Настройка базовой информации

- В Container Platform перейдите в Workloads > Deployments в левой боковой панели.

- Нажмите Create Deployment.

- Выберите или введите образ и нажмите Confirm.

Примечание: При использовании образов из репозитория, интегрированного в веб-консоль, можно фильтровать образы по Already Integrated. Integration Project Name, например, образы (docker-registry-projectname), включают имя проекта projectname в этой веб-консоли и имя проекта containers в репозитории образов.

-

В разделе Basic Info настройте декларативные параметры для workloads Deployment:

Параметры Описание Replicas Определяет желаемое количество реплик Pod в Deployment (по умолчанию: 1). Настраивается в зависимости от требований к нагрузке.More > Update Strategy Настраивает стратегию rollingUpdateдля обновлений без простоя:

Max surge (maxSurge):- Максимальное количество Pod, которое может превышать желаемое число реплик во время обновления.

- Принимает абсолютные значения (например,

2) или проценты (например,20%). - Вычисление процентов:

ceil(current_replicas × percentage). - Пример: 4.1 →

5при расчете от 10 реплик.

maxUnavailable):- Максимальное количество Pod, которые могут быть временно недоступны во время обновления.

- Процентные значения не могут превышать

100%. - Вычисление процентов:

floor(current_replicas × percentage). - Пример: 4.9 →

4при расчете от 10 реплик.

1. Значения по умолчанию:maxSurge=1,maxUnavailable=1, если явно не заданы.

2. Незапущенные Pod (например, в состоянияхPending/CrashLoopBackOff) считаются недоступными.

3. Одновременные ограничения:-

maxSurgeиmaxUnavailableне могут оба быть0или0%. - Если процентные значения для обоих параметров равны

0, Kubernetes принудительно устанавливаетmaxUnavailable=1для обеспечения прогресса обновления.

Для Deployment с 10 репликами:-

maxSurge=2→ Общее количество Pod во время обновления:10 + 2 = 12. maxUnavailable=3→ Минимальное количество доступных Pod:10 - 3 = 7.- Это обеспечивает доступность при контролируемом развертывании.

Процедура — Настройка Pod

Примечание: В кластерах с разной архитектурой, при развертывании образов одной архитектуры, убедитесь, что настроены правильные Node Affinity Rules для планирования Pod.

-

В разделе Pod настройте параметры контейнерного рантайма и управления жизненным циклом:

Параметры Описание Volumes Монтирование персистентных томов в контейнеры. Поддерживаемые типы томов: PVC,ConfigMap,Secret,emptyDir,hostPathи др. Для деталей реализации смотрите Volume Mounting Guide.Pull Secret Требуется только при загрузке образов из сторонних реестров (через ручной ввод URL образа).

Примечание: Секрет для аутентификации при загрузке образа из защищенного реестра.Close Grace Period Время (по умолчанию: 30s), отведенное Pod для корректного завершения после получения сигнала на остановку.

- В этот период Pod завершает текущие запросы и освобождает ресурсы.

- Установка0приводит к немедленному удалению (SIGKILL), что может вызвать прерывание запросов.

- Node Affinity Rules

| Параметры | Описание |

|---|---|

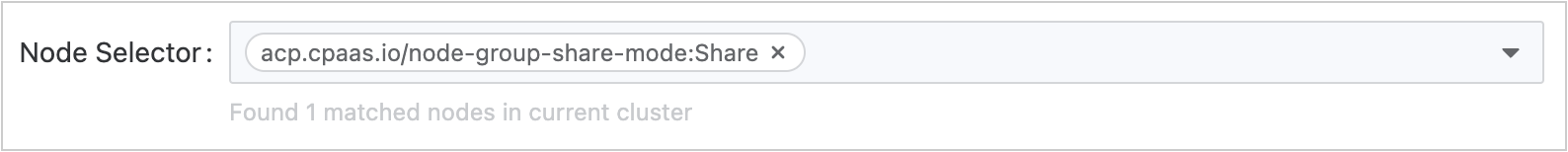

| More > Node Selector | Ограничивает Pod узлами с определенными метками (например, kubernetes.io/os: linux).  |

| More > Affinity | Определяет тонкие правила планирования на основе существующих. Типы Affinity:

|

- Настройка сети

-

Kube-OVN

Параметры Описание Bandwidth Limits Обеспечивает QoS для сетевого трафика Pod: - Ограничение исходящего трафика: Максимальная скорость исходящего трафика (например,

10Mbps). - Ограничение входящего трафика: Максимальная скорость входящего трафика.

Subnet Назначение IP из предопределенного пула подсети. Если не указано, используется подсеть по умолчанию для namespace. Static IP Address Привязка постоянных IP-адресов к Pod: - Несколько Pod из разных Deployments могут претендовать на один IP, но одновременно использовать его может только один Pod.

- Критично: Количество статических IP должно быть ≥ количеству реплик Pod.

- Ограничение исходящего трафика: Максимальная скорость исходящего трафика (например,

-

Calico

Параметры Описание Static IP Address Назначение фиксированных IP с жестким ограничением уникальности: - Каждый IP может быть привязан только к одному Pod в кластере.

- Критично: Количество статических IP должно быть ≥ количеству реплик Pod.

-

Процедура — Настройка контейнеров

-

В разделе Container настройте соответствующую информацию согласно следующим инструкциям.

Параметры Описание Resource Requests & Limits - Requests: Минимальные CPU/память, необходимые для работы контейнера.

- Limits: Максимальные CPU/память, разрешённые во время выполнения контейнера. Для определения единиц смотрите Resource Units.

- Без коэффициента overcommit:

Если существуют квоты ресурсов namespace: Запросы/лимиты контейнера наследуют значения по умолчанию namespace (можно изменить).

Если квот нет: Нет значений по умолчанию; задается пользовательский Request. - С коэффициентом overcommit:

Запросы рассчитываются автоматически какLimits / Overcommit ratio(неизменяемо).

- Request ≤ Limit ≤ максимальная квота namespace.

- Изменение коэффициента overcommit требует пересоздания pod для вступления в силу.

- Коэффициент overcommit отключает ручную настройку request.

- При отсутствии квот namespace — нет ограничений ресурсов контейнера.

Extended Resources Настройка расширенных ресурсов, доступных в кластере (например, vGPU, pGPU). Volume Mounts Конфигурация персистентного хранилища. Смотрите Инструкции по монтированию томов.

Операции:- Существующие тома pod: нажмите Add

- Отсутствуют тома pod: нажмите Add & Mount

mountPath: путь в файловой системе контейнера (например,/data)subPath: относительный путь файла/директории внутри тома.

ДляConfigMap/Secret: выбор конкретного ключаreadOnly: монтировать только для чтения (по умолчанию: чтение-запись)

Ports Открытие портов контейнера.

Пример: Открыть TCP порт6379с именемredis.

Поля:protocol: TCP/UDPPort: открываемый порт (например,6379)name: DNS-совместимый идентификатор (например,redis)

Startup Commands & Arguments Переопределение стандартных ENTRYPOINT/CMD:

Пример 1: Выполнитьtop -b

- Command:["top", "-b"]

- ИЛИ Command:["top"], Args:["-b"]

Пример 2: Вывод$MESSAGE:/bin/sh -c "while true; do echo $(MESSAGE); sleep 10; done"

Смотрите Определение команд.More > Environment Variables - Статические значения: прямые пары ключ-значение

- Динамические значения: ссылки на ключи ConfigMap/Secret, поля pod (

fieldRef), метрики ресурсов (resourceFieldRef)

More > Referenced ConfigMaps Внедрение целого ConfigMap/Secret как переменных окружения. Поддерживаемые типы Secret: Opaque,kubernetes.io/basic-auth.More > Health Checks - Liveness Probe: Проверка здоровья контейнера (перезапуск при сбое)

- Readiness Probe: Проверка доступности сервиса (удаление из endpoints при сбое)

More > Log Files Настройка путей логов:

- По умолчанию: сборstdout

- Шаблоны файлов: например,/var/log/*.log

Требования:- Драйвер хранения

overlay2: поддерживается по умолчанию devicemapper: необходимо вручную монтировать EmptyDir в каталог логов- Узлы Windows: обеспечить монтирование родительского каталога (например,

c:/aдляc:/a/b/c/*.log)

More > Exclude Log Files Исключение определённых логов из сбора (например, /var/log/aaa.log).More > Execute before Stopping Выполнение команд перед завершением контейнера.

Пример:echo "stop"

Примечание: Время выполнения команды должно быть меньшеterminationGracePeriodSecondspod. -

Нажмите Add Container (вверху справа) ИЛИ Add Init Container.

Смотрите Init Containers. Init Container:

- Запускается перед контейнерами приложения (последовательное выполнение).

- Освобождает ресурсы после завершения.

- Удаление разрешено, если:

- Pod содержит >1 контейнера приложения И ≥1 init контейнер.

- Не разрешено для Pod с одним контейнером приложения.

-

Нажмите Create.

Справочная информация

Инструкции по монтированию томов

| Тип | Назначение |

|---|---|

| Persistent Volume Claim | Привязывает существующий PVC для запроса персистентного хранилища. Примечание: Выбираются только привязанные PVC (с ассоциированным PV). Непривязанные PVC вызовут ошибку создания pod. |

| ConfigMap | Монтирует полные/частичные данные ConfigMap как файлы:

|

| Secret | Монтирует полные/частичные данные Secret как файлы:

|

| Ephemeral Volumes | Временный том, предоставляемый кластером, с возможностями:

|

| Empty Directory | Временное хранилище для совместного использования между контейнерами в одном pod:

|

| Host Path | Монтирует директорию хоста (должна начинаться с /, например, /volumepath). |

Проверки здоровья

Управление Deployments

Управление Deployment с помощью CLI

Просмотр Deployment

-

Проверьте, что Deployment создан.

-

Получите подробную информацию о вашем Deployment.

Обновление Deployment

Выполните следующие шаги для обновления Deployment:

-

Обновим Pods nginx, чтобы использовать образ nginx:1 .16.1.

или используйте следующую команду:

Также можно отредактировать Deployment и изменить

.spec.template.spec.containers[0].imageсnginx:1.14.2наnginx:1.16.1: -

Для просмотра статуса развертывания выполните:

Выполните

kubectl get rs, чтобы увидеть, что Deployment обновил Pods, создав новый ReplicaSet и масштабируя его до 3 реплик, а старый ReplicaSet масштабируется до 0 реплик.Выполнение

kubectl get podsтеперь должно показывать только новые Pods:

Масштабирование Deployment

Вы можете масштабировать Deployment с помощью следующей команды:

Откат Deployment

-

Предположим, что вы ошиблись при обновлении Deployment, указав имя образа как

nginx:1.161вместоnginx:1.16.1: -

Развертывание застряло. Вы можете проверить это, посмотрев статус развертывания:

Удаление Deployment

Удаление Deployment также удалит управляемый им ReplicaSet и все связанные Pods.

Управление Deployment через веб-консоль

Просмотр Deployment

Вы можете просмотреть Deployment, чтобы получить информацию о вашем приложении.

- В Container Platform перейдите в Workloads > Deployments.

- Найдите нужный Deployment.

- Нажмите на имя Deployment, чтобы увидеть Details, Topology, Logs, Events, Monitoring и др.

Обновление Deployment

- В Container Platform перейдите в Workloads > Deployments.

- Найдите нужный Deployment.

- В выпадающем меню Actions выберите Update, чтобы открыть страницу редактирования Deployment.

Удаление Deployment

- В Container Platform перейдите в Workloads > Deployments.

- Найдите нужный Deployment.

- В выпадающем меню Actions нажмите кнопку Delete в колонке операций и подтвердите.

Устранение неполадок с помощью CLI

Если у Deployment возникают проблемы, вот несколько распространенных методов диагностики.

Проверка статуса Deployment

Проверка статуса ReplicaSet

Проверка статуса Pod

Просмотр логов

Вход в Pod для отладки

Проверка конфигурации здоровья

Убедитесь, что livenessProbe и readinessProbe настроены корректно, а конечные точки проверки здоровья вашего приложения отвечают правильно. Устранение неполадок с проверками

Проверка лимитов ресурсов

Убедитесь, что запросы и лимиты ресурсов контейнеров разумны и контейнеры не завершаются из-за нехватки ресурсов.